Что нового появилось в Apple Intelligence

Изменения, которые мы ждали (не все).

Давайте от ненужного к нужному: во-первых, появилась фишка Mixmoji, которая позволяет комбинировать эмодзи между собой и направлять ИИ, вводя промты.

Во-вторых, разработчикам дадут доступ к Image Playground API, чтобы было ещё больше фиговых эмодзи.

Далее действительно важные обновления: Live Translation переводит речь на ходу во время сообщений, звонков и видеочатов. Теперь вы точно будете знать, что вам говорит ваша бабушка из Франции!

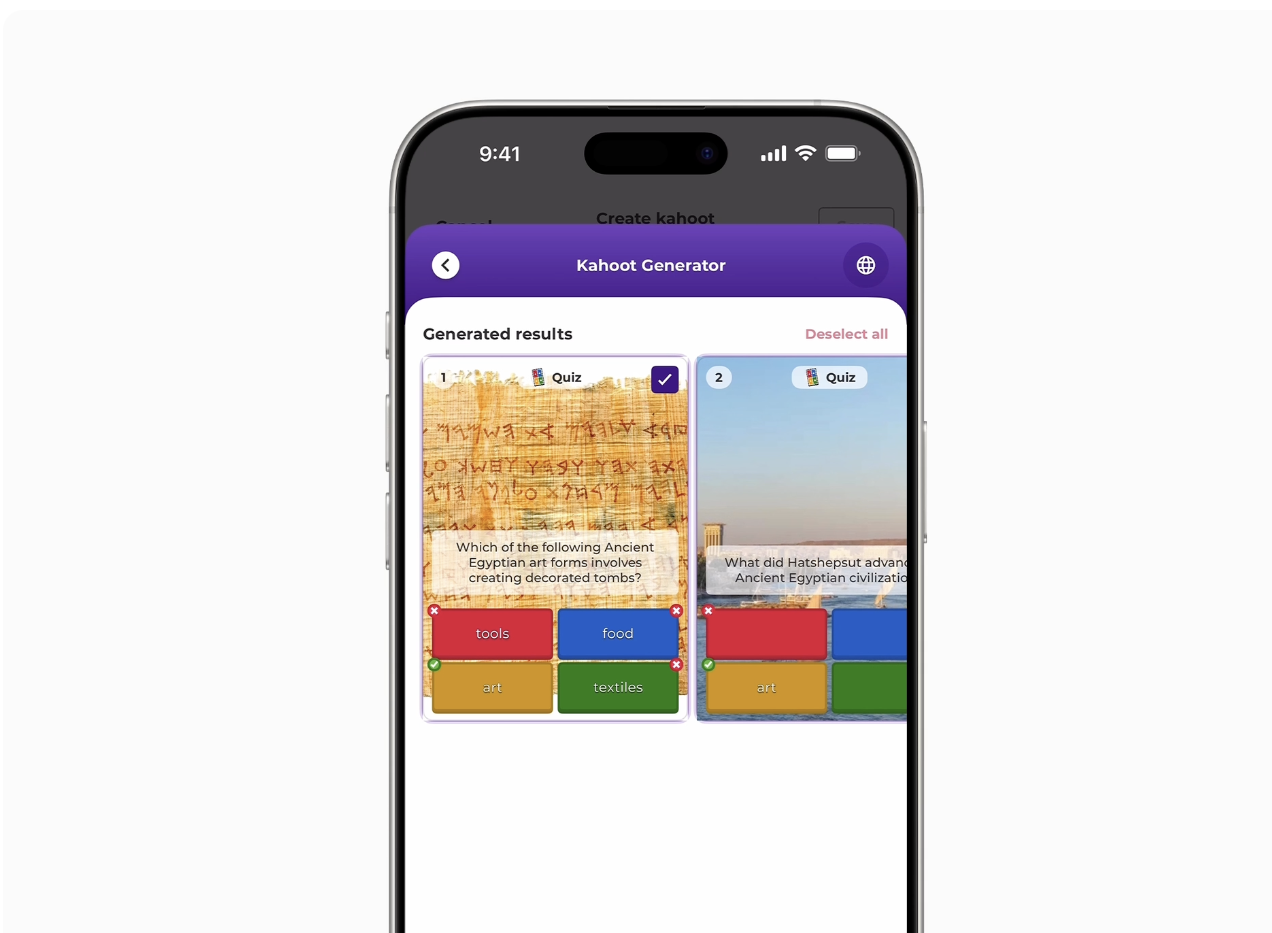

Разработчикам дадут доступ к новому SDK. При этом работать с ним смогут даже Android-приложения!

Visual Intelligence научился понимать информацию на экране. Можно задать любой вопрос ChatGPT и сразу запустить поиск в Google.

Активировать Visual Intelligence прямо в меню скриншота. ИИ понимает контекст и предлагает различные рекомендации на его основе. Например, вы смотрите на какое-то событие, и «Визуальный интеллект» говорит: «Давай создадим напоминание».

Apple Watch получили ИИ-помощника для тренировок Workout Buddy. Ассистент анализирует историю тренировок и текущие показатели, давая на их основе голосовые рекомендации. Да, вы прочитали всё верно. Функция будет доступна для владельцев фирменных часов Apple и любых Bluetooth-наушников.

Как и ожидалось, сторонние разработчики получат доступ к программе Apple Foundation Models, которая позволит им использовать локальные мощности ИИ на всех устройствах компании.

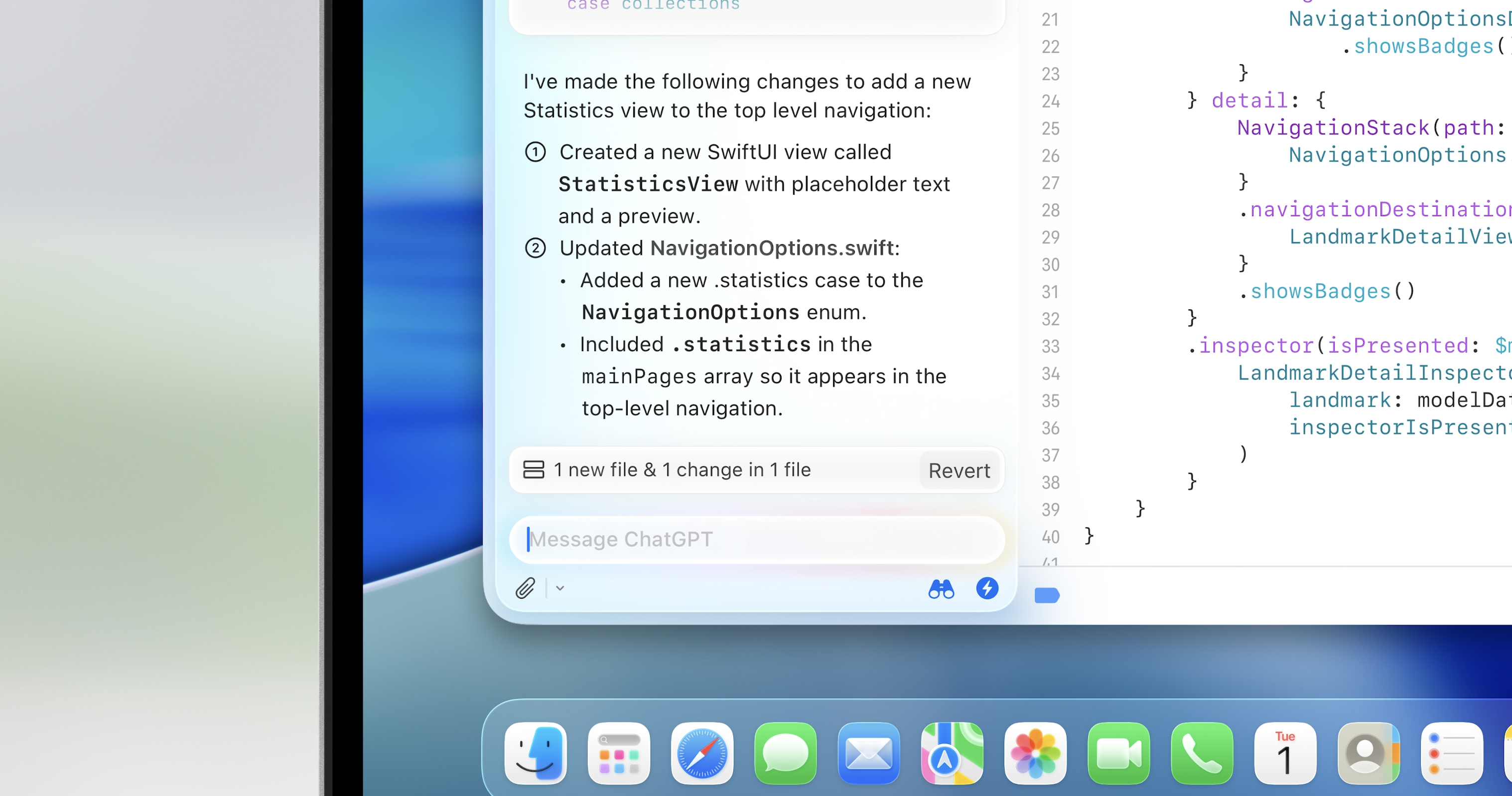

Кроме того, разработчики получат доступ к умному ассистенту для вайб-кодинга на Swift.

В XCode появится предиктивный ввод, а также ChatGPT для консультаций. Swift UI получит удобные инструменты для редактирования интерфейса приложений.