Нейросетевая нефотокамера

Запускаем завод по сжиганию фотографов?

Чем лучше нейросети рисуют пальцы и кошкодевочек, тем чаще возникают споры об обесценивании творческих профессий. Не обошла эта беда и фотографов: в фоточатах уже не один месяц бушуют баталии на тему генеративных ИИ, а недавнее обновление фотошопа только подлило масла в огонь.

Вообще, алгоритмы в фотографии присутствуют уже давно. Если бы не они, то мобильные телефоны до сих пор бы снимали на уровне моделей середины прошлого десятилетия. Причём с каждым годом от чистой фотографии, получаемой с матрицы, остаётся всё меньше и меньше — взять хотя бы недавнее разоблачение «лунного» режима Galaxy S20 Ultra. Если вкратце, то он рисует кратеры практически на любом объекте, напоминающем Луну, даже если это белый кружок на чёрном экране монитора.

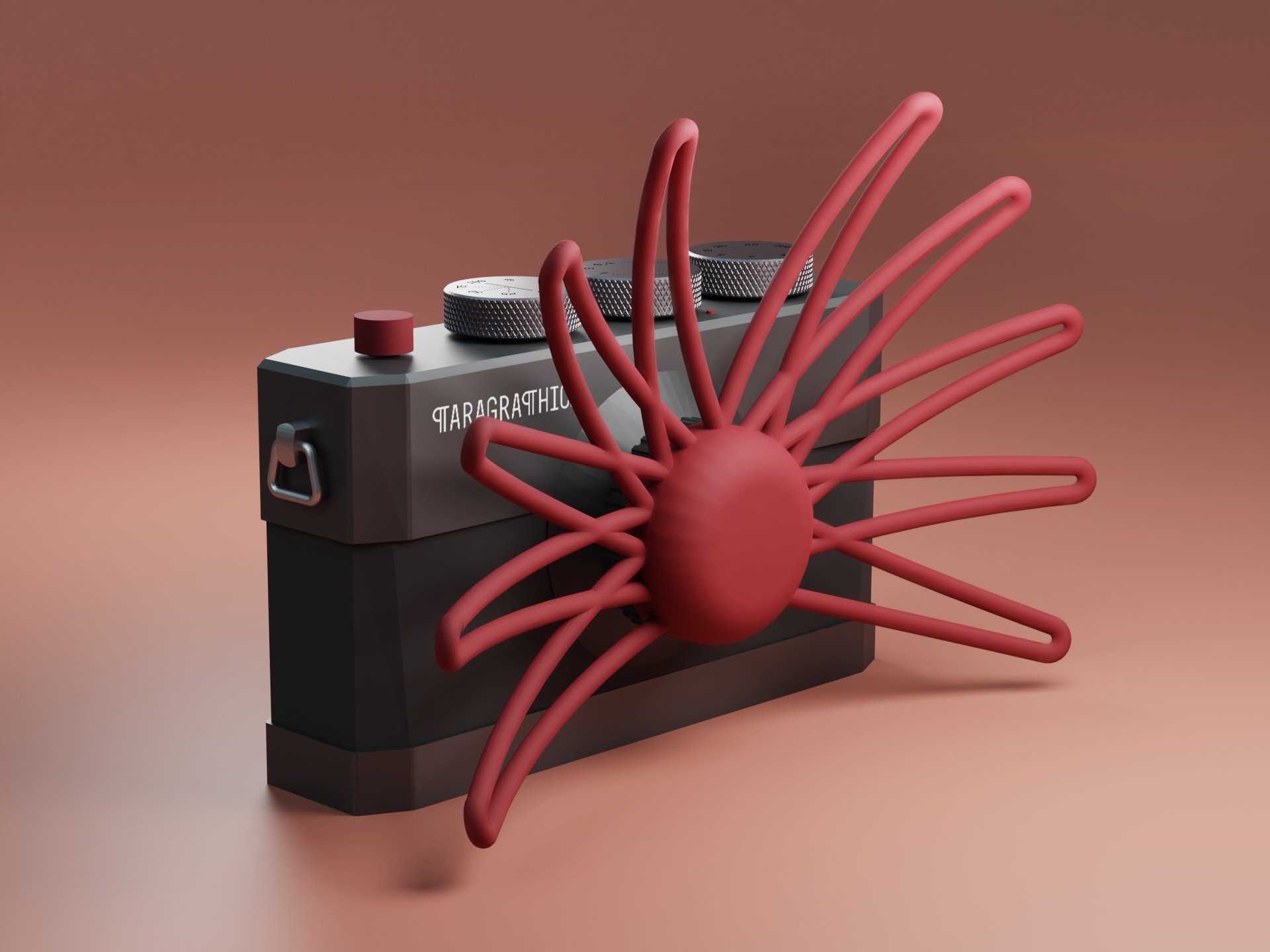

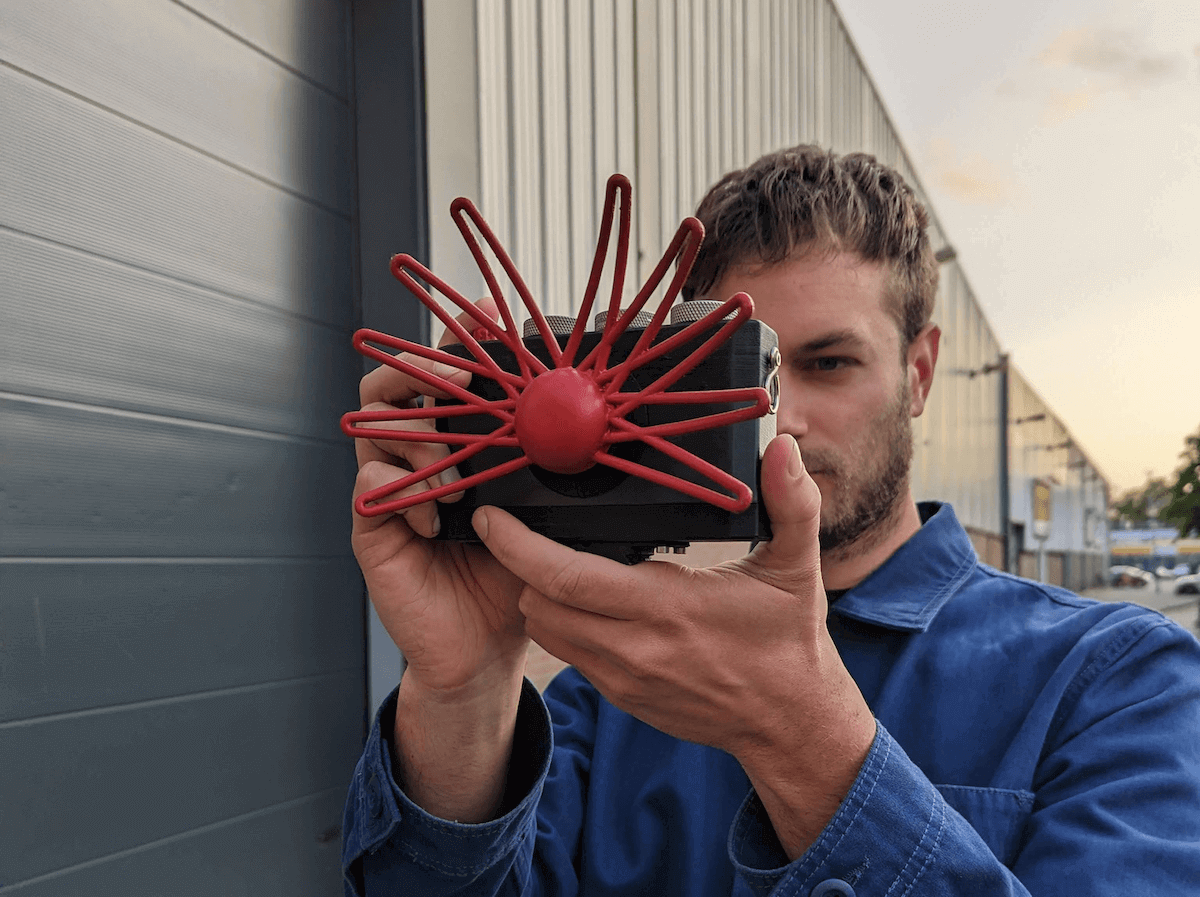

Нидерландский дизайнер Bjørn Karmann решил довести концепцию нейросетевой фотографии до абсурда и на основе Rassberry Pi собрал прототип «камеры» Paragraphica без объектива и матрицы.

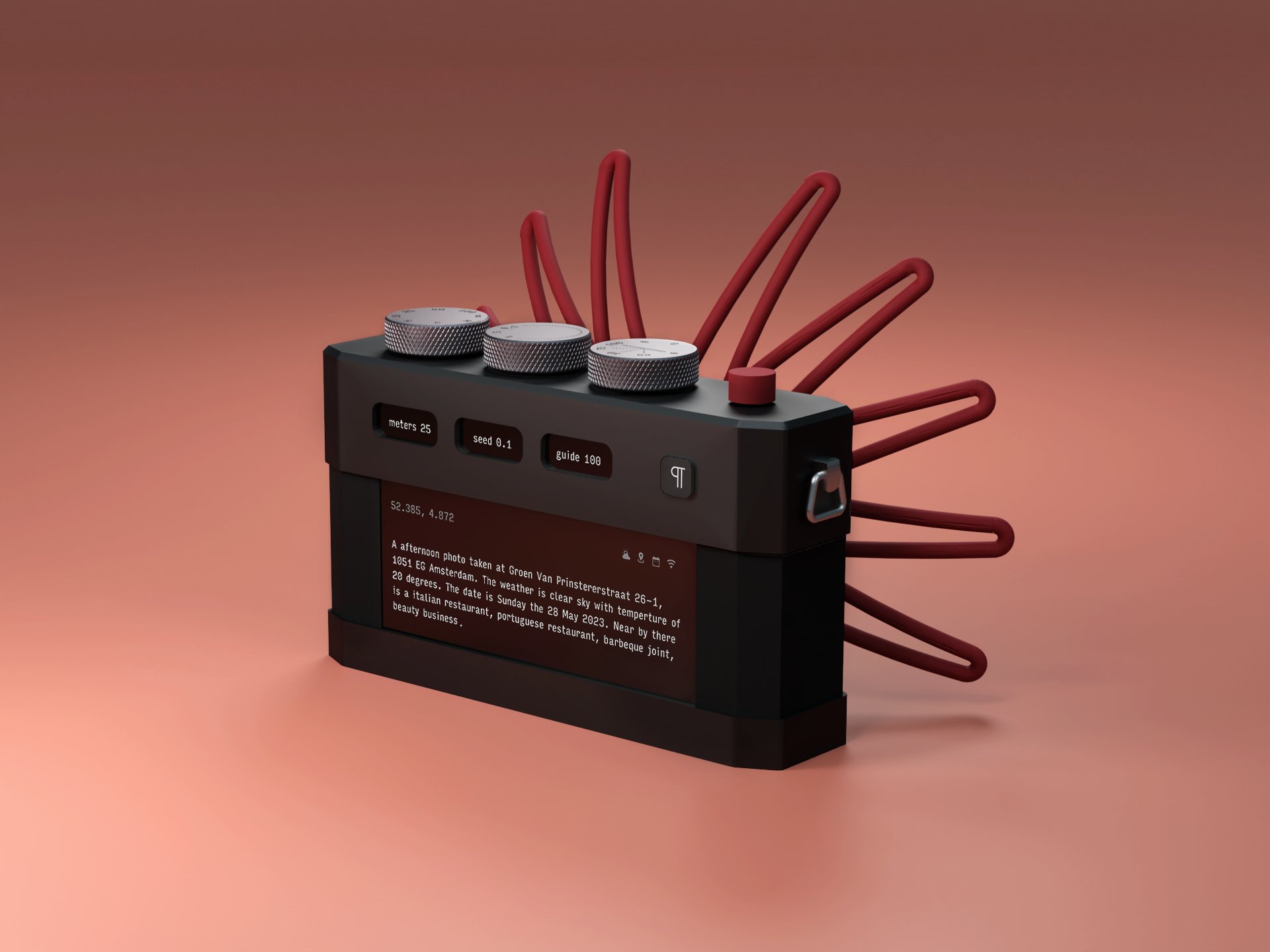

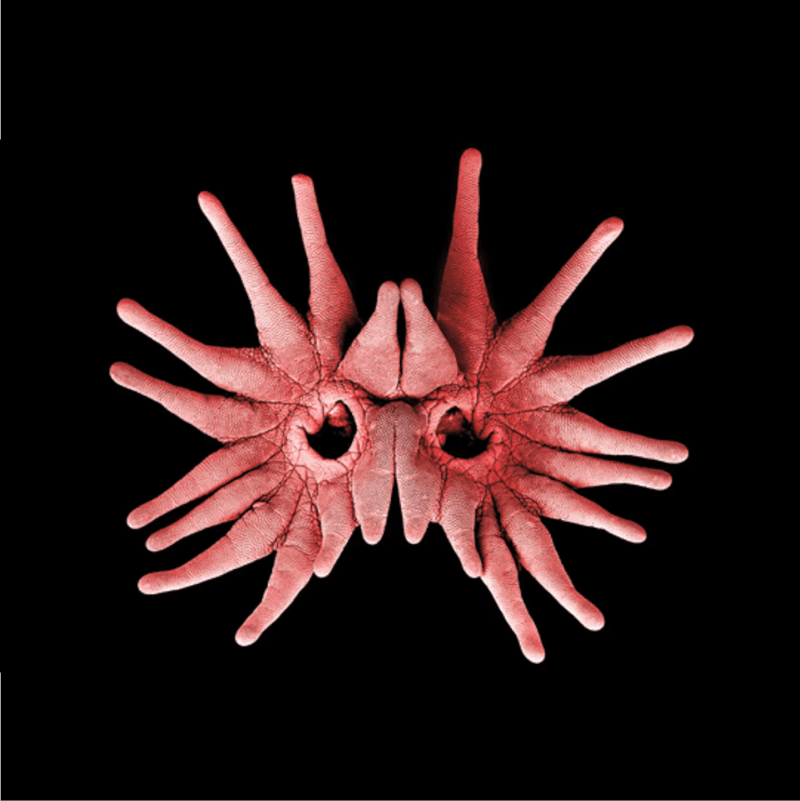

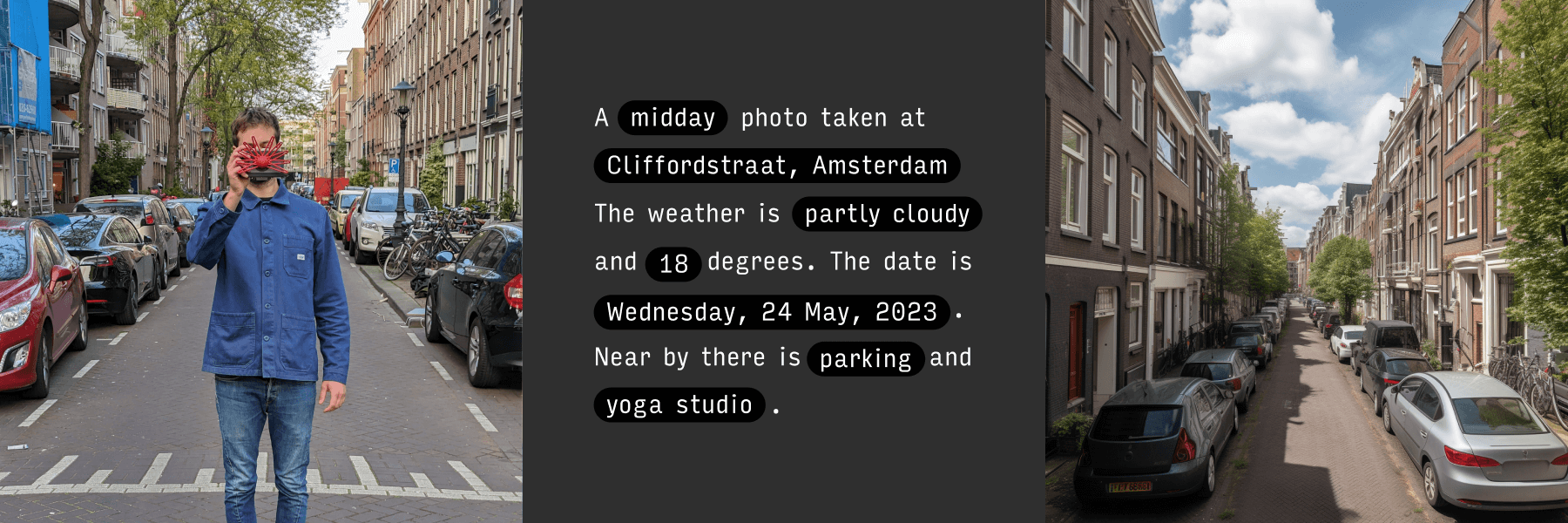

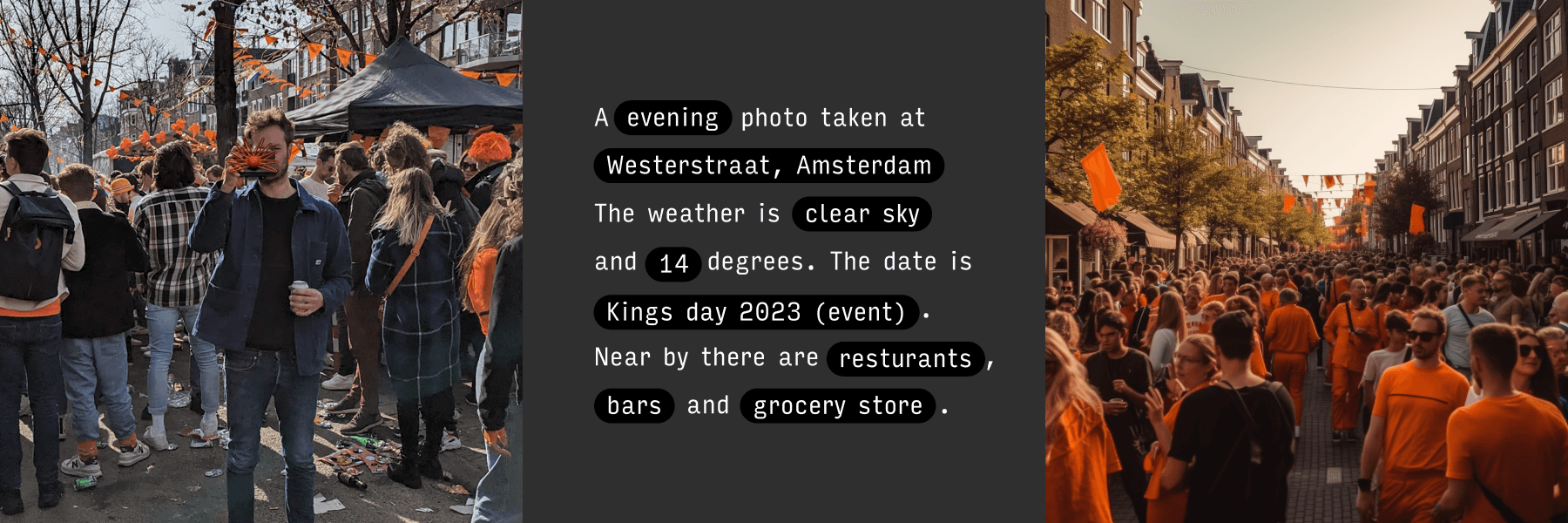

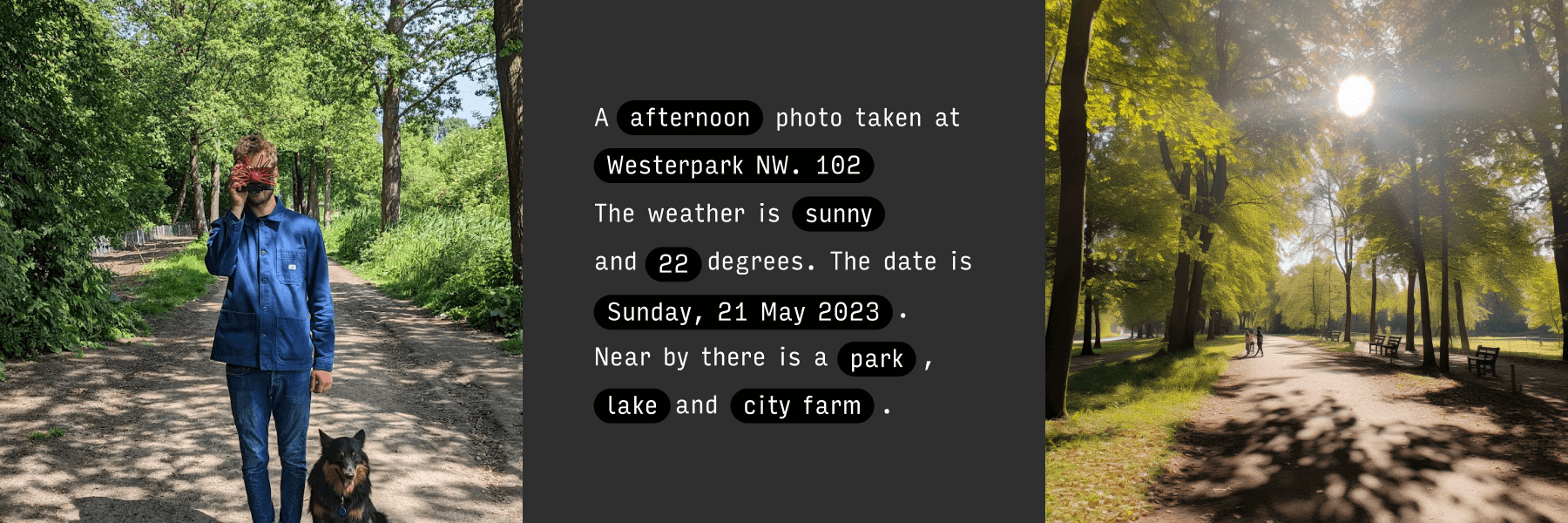

Устройство получает данные о геолокации, погоде, дате и времени суток, переводит их в текстовый запрос для Stable Diffusion и выводит результат в виде изображения на экран. Корпус арт-объекта, а иначе это и не назовёшь, выполнен с отсылкой к звездорылу — слепому млекопитающему из семейства кротовых, который ориентируется в пространстве только с помощью кожаных наростов на мордочке.

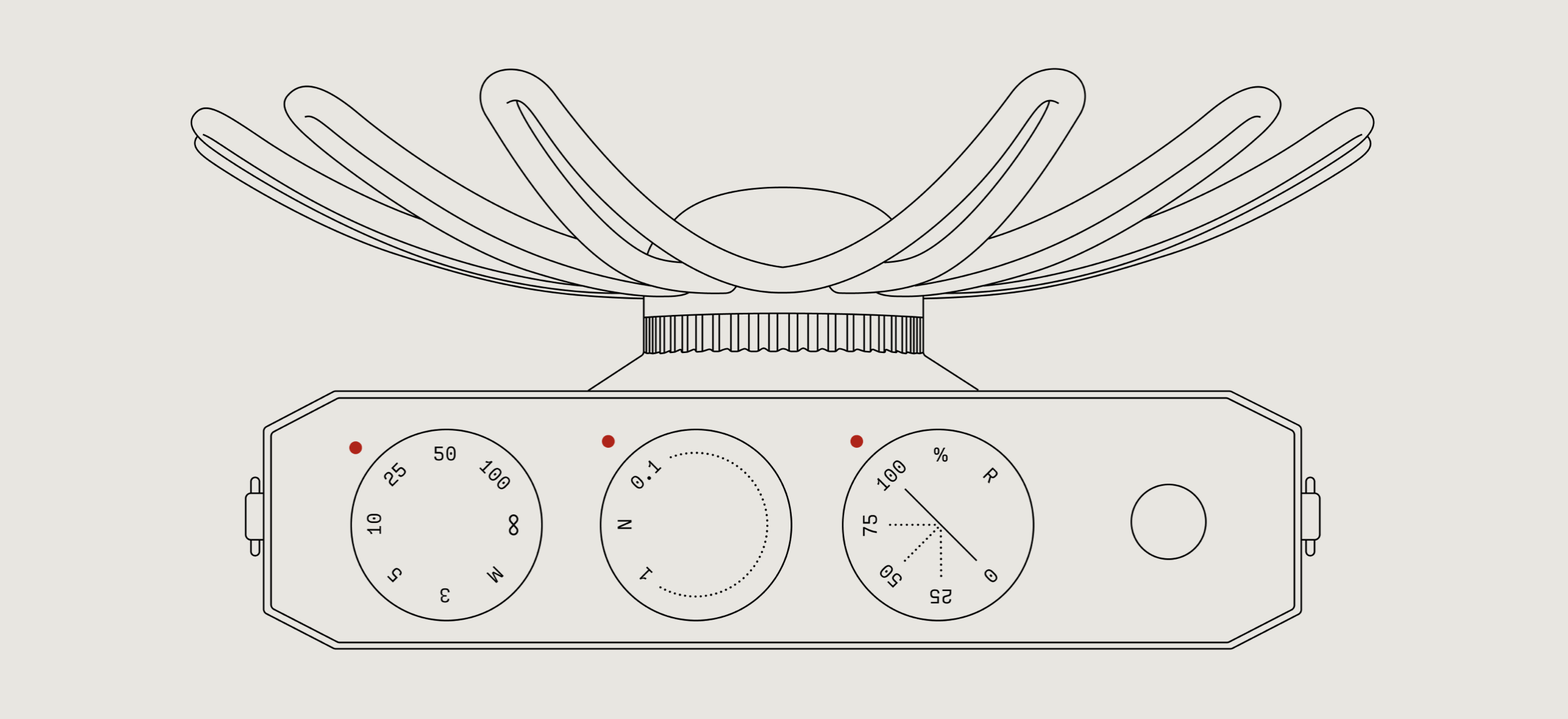

Как и во многих «традиционных» камерах, у Paragraphica есть три колёсика регулировки. Обычно они позволяют настраивать значения выдержки, ISO и диафрагмы, но тут всё иначе. Первое колёсико позволяет контролировать радиус, в котором алгоритм будет искать объекты для более точного позиционирования на карте, а остальные две крутилки отвечают за точность запроса и параметры генерации.

Естественно, часто получаемые изображения далеки от того, что вживую видит человек или получила бы камера на месте. Но в некоторых случаях сходство просто поразительное. В популярных локациях сгенерированные «фотографии» довольно трудно отличить от настоящих. В Твиттере создателям посоветовали прикрутить синхронизацию местоположения с сервисом Google Street View. На что автор проекта ответил, что и не стремился к фотореалистичной точности, а работал над устройством, которое позволяло бы запечатлеть «образ места» и показать то, как его видит нейросеть.

Скорее всего, проект так и останется в виде штучного прототипа и вряд ли доберётся до массового производства. Зато можно попробовать поиграться с алгоритмами, заложенными в устройстве: разработчики сделали специальный сайт, но он пока очень долго открывается из-за высокой нагрузки.