Apple научит ИИ выявлять случаи жестокого обращения с детьми на фотографиях в iPhone

Однако у экспертов есть вопросы к системе.

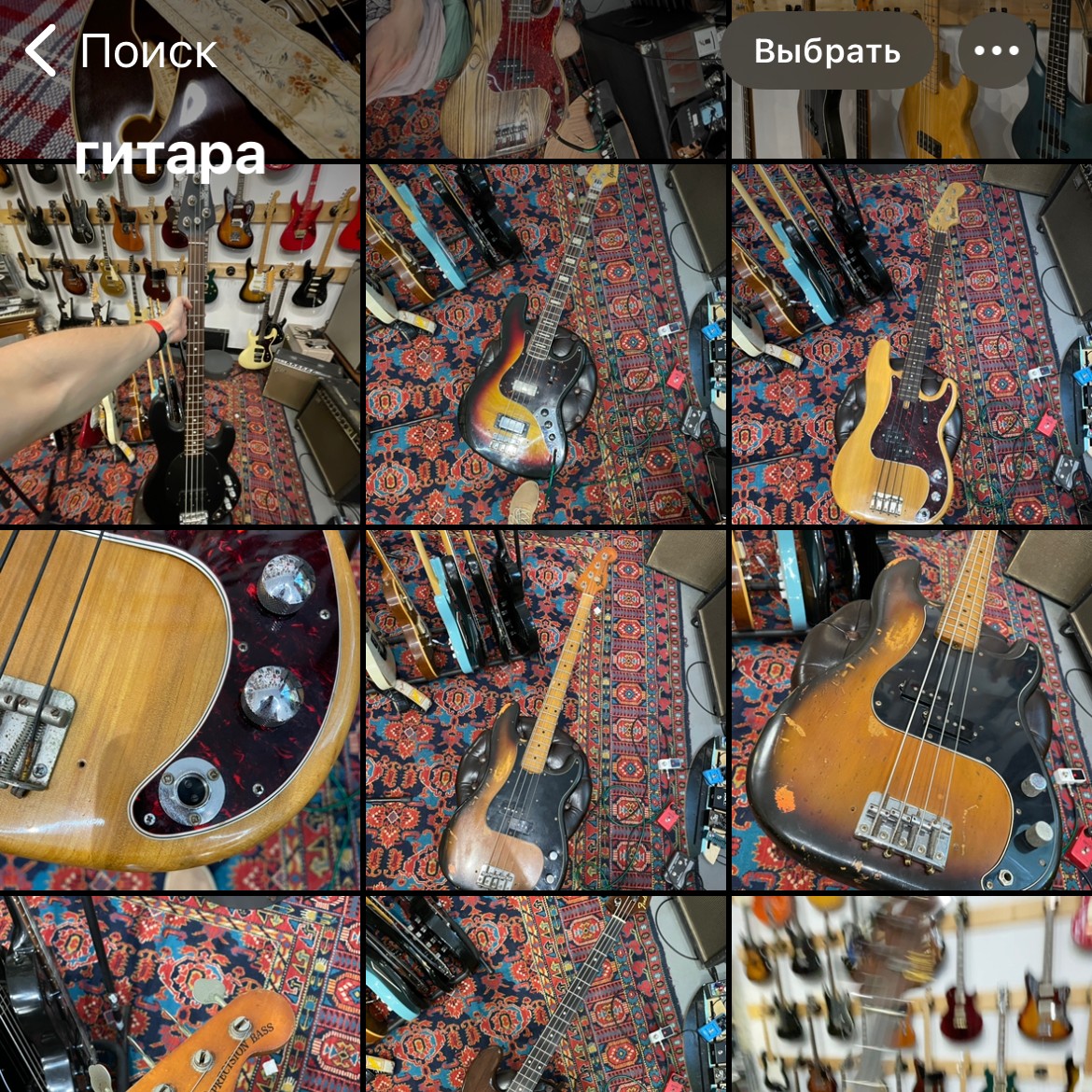

С недавних пор Apple реализовала в приложении «Фото» поиск по содержанию. Я часто пользуюсь этой штукой. Например, зачем-то постоянно ищу сфотографированные гитары, а недавно вот потребовалось найти фото своего загранпаспорта.

Система работает очень хорошо (но у Google всё-таки лучше: там мне выдало бы даже видео, где кто-то произнёс слово «гитара»). Однако Apple продолжает улучшать систему. Если верить профессору криптографии из Университета Джона Хопкинса Мэттью Грину, следующий этап — запуск системы обнаружения CSAM. Эта аббревиатура расшифровывается как Child Sexual Abuse Material, то есть ИИ, разработанный Apple, будет искать детскую порнографию и другие моменты сексуального насилия над детьми.

Точно так же, как этот инструмент находит гитары на фотографиях и видеозаписях, система будет находить объекты и сцены, являющиеся объектом CSAM.

По мнению эксперта, внедрение этой системы может стать ошибкой. По крайней мере, современные ИИ дают большое количество ложных срабатываний. Например, в том же поиске по гитарам я нашёл фотографию двух людей. У одного в руках была виолончель, а у девушки — скрипка. И суть в том, что на фотографии может быть что угодно. ИИ может это воспринять как контент с сексуальным насилием над ребёнком.

Тут в дело вступает человек. Он сидит со стороны Apple и проверяет фотографии, на которые указала система обнаружения.

Теоретически Apple может дать доступ к системе правительствам, чтобы они сами могли анализировать контент. Но Мэттью Грин задаётся вопросом: представьте, что будет, если доступ получит авторитарное правительство во главе с тираном?

По данным профессора, Apple запустит систему обнаружения CSAM в ближайшие дни.